Datenschutz bei KI-Tools: Was ChatGPT, Claude & Co. wirklich mit deinen Daten tun

Was KI über dich weiss – Datenschutz bei ChatGPT & Co.

„Kostenlos“ ist bei Künstlicher Intelligenz ein relativer Begriff. Meistens bezahlst du mit deinen Daten. KI-Tools wie ChatGPT, Claude, Gemini oder Copilot begleiten uns längst im Alltag: Sie schreiben Texte, fassen Meetings zusammen, erstellen Code oder beantworten Fragen. Doch während Millionen Menschen mit diesen Modellen kommunizieren, fragen sich nur wenige, was eigentlich mit ihren Eingaben geschieht.

Dieser Artikel beleuchtet, wie KI-Dienste tatsächlich mit deinen Daten umgehen, welche Risiken daraus entstehen und wie du als Nutzer:in deine Privatsphäre besser schützen kannst – nach Schweizer und EU-Datenschutzrecht.

Wie KI-Tools Daten verarbeiten

KI-Modelle lernen nicht aus dem Nichts. Sie verarbeiten enorme Mengen an Text, Bildern und Code, um Zusammenhänge zu erkennen. Wenn du einen Prompt schreibst, wird dieser an die Server des Anbieters gesendet, dort interpretiert und zur Antwortgenerierung verwendet.

Laut der Datenschutzrichtlinie von OpenAI werden Chatverläufe bis zu 30 Tage gespeichert, um Missbrauch zu erkennen oder Systemfehler zu untersuchen. Inhalte aus kostenlosen oder Pro-Konten können in anonymisierter Form zur Qualitätsverbesserung verwendet werden – sofern man das Training nicht deaktiviert. Nutzer:innen von ChatGPT Team und Enterprise sind davon ausgenommen; ihre Daten werden laut OpenAI Business Data-Policy weder zu Trainingszwecken genutzt noch mit Dritten geteilt.

Auch Anthropic – Hersteller von Claude – speichert Eingaben kurzfristig (derzeit 90 Tage), um Missbrauch zu verhindern, verspricht aber, keine Kundendaten für das Training zu verwenden.

Googles Gemini-Richtlinie sieht dagegen vor, dass Nutzerdaten zur „Verbesserung von Produkten“ verwendet werden können, sofern die Option in den Kontoeinstellungen aktiviert ist. Wer das nicht möchte, kann das Sammeln im Google-Dashboard deaktivieren.

Microsofts Copilot-Datenschutzseite beschreibt ein hybrides Modell: In Unternehmensumgebungen bleiben Daten innerhalb des Microsoft-Tenants; für Privatnutzer gelten die allgemeinen Microsoft-Privacy-Terms.

In der Schweiz regelt das revidierte Datenschutzgesetz (revDSG) seit 2023 den Umgang mit personenbezogenen Daten. Es ähnelt der europäischen Datenschutzgrundverordnung (DSGVO) – fordert also Transparenz, Datensparsamkeit und klare Zweckbindung.

Das Problem: Viele KI-Dienste betreiben ihre Server ausserhalb Europas. Damit greifen Gesetze wie der US CLOUD Act, der amerikanischen Behörden unter bestimmten Umständen Zugriff auf gespeicherte Daten erlaubt – selbst, wenn diese physisch in Europa liegen.

Ein Experiment mit Folgen

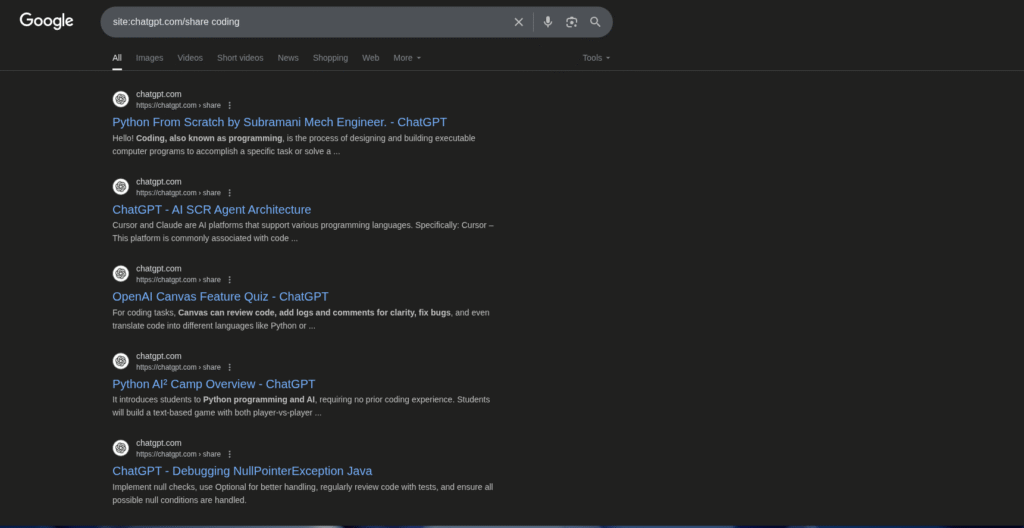

Wie fragil Datenschutz bei KI sein kann, zeigte ein Vorfall im Sommer 2025:

OpenAI testete eine Funktion, mit der Nutzer ihre ChatGPT-Konversationen öffentlich teilen konnten. Innerhalb weniger Tage stellte sich heraus, dass einige dieser öffentlichen Chats von Google indexiert worden waren – private Dialoge tauchten in Suchergebnissen auf. Die Funktion wurde sofort gestoppt, aber der Schaden war da.

t3n berichtete über das Experiment und sprach von einem „PR-GAU“. Auch TechCrunch und FastCompany bestätigten den Vorfall. Für Datenschützer war das ein Warnsignal: Selbst ein führender Anbieter kann durch kleine Designfehler massenhaft private Daten preisgeben.

Datenschutzrisiken mit KI-Tools im Berufsalltag

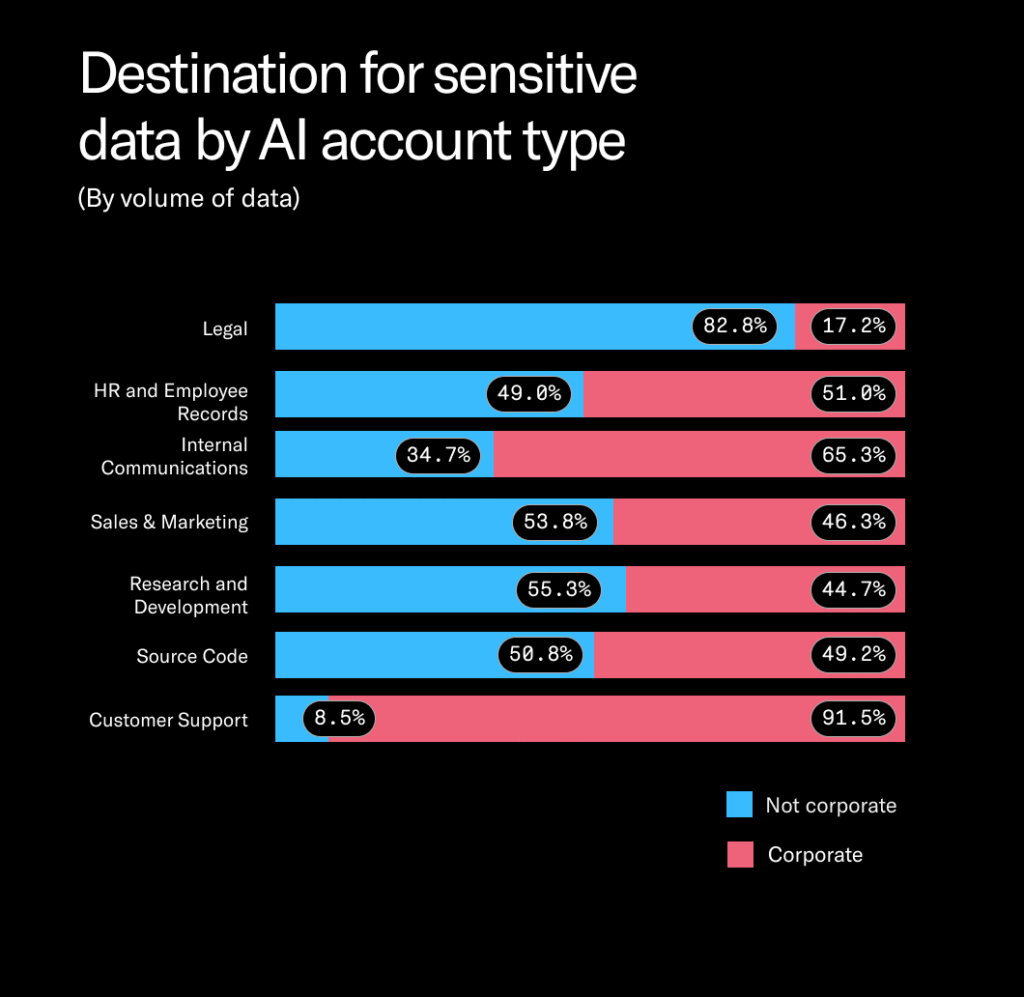

Die grössten Datenschutzverletzungen entstehen nicht durch Hacker, sondern durch Routine. Viele Mitarbeitende verwenden KI-Tools im Arbeitsalltag, ohne Genehmigung der IT-Abteilung. Sie lassen ChatGPT E-Mails umformulieren, analysieren Kundendaten oder schreiben Berichte – und kopieren dabei oft vertrauliche Informationen in ein externes System.

Das Phänomen nennt sich Shadow AI: Der Einsatz nicht freigegebener KI-Tools in Unternehmen. Laut einer Gartner-Studie werden bis 2026 rund 70 % der Unternehmen damit konfrontiert sein. Für Firmen bedeutet das nicht nur ein Sicherheits-, sondern auch ein Compliance-Risiko.

Freelancer und kleine Agenturen sind ebenfalls betroffen: Tools wie Notion AI oder Canva Magic Write nutzen externe APIs. Wer Kundendaten oder sensible Informationen eingibt, riskiert also unbewusst einen Verstoss gegen Datenschutzauflagen.

Schutzmassnahmen, die wirklich helfen

- Keine sensiblen Daten eingeben

Alles, was du nicht öffentlich teilen würdest, gehört nicht in einen Prompt. Dazu zählen Namen, Kundendaten, Gesundheitsinformationen oder interne Strategien. - Verläufe regelmässig löschen

ChatGPT, Claude und Gemini bieten Funktionen zum Löschen von Chat-Historien. In ChatGPT findet sich diese Option unter Settings → Data Controls. - Nur Dienste mit klarer Datenschutzpolitik nutzen

Bevor du ein neues Tool testest, lies dessen Datenschutzerklärung. Achte auf Serverstandort, Verschlüsselung und Datenlöschung. - Self-Hosted- oder API-Lösungen bevorzugen

Mit lokalen Tools wie Ollama oder GPT4All bleiben deine Daten vollständig auf deinem Rechner. - Interne KI-Richtlinien definieren

Unternehmen sollten festlegen, welche Daten verarbeitet werden dürfen und welche Tools erlaubt sind. Eine kurze AI-Policy verhindert viele Fehler.

Datenschutzfreundliche Alternativen

Einige europäische Anbieter zeigen, dass Datenschutz und KI-Nutzung vereinbar sind.

Das deutsche Unternehmen Aleph Alpha entwickelt Modelle, die vollständig in der EU betrieben werden. Es trennt strikt zwischen Trainings- und Nutzungsdaten.

Das französische Start-up Mistral AI setzt auf Open-Source-Modelle, die lokal installiert werden können. Auch DeepL Write arbeitet DSGVO-konform und speichert Nutzereingaben laut Datenschutzrichtlinie nicht dauerhaft.

Unternehmen mit höheren Anforderungen greifen zu ChatGPT Enterprise, Claude for Work oder Microsoft Copilot for Microsoft 365. Diese Lösungen speichern keine Nutzereingaben für Trainingszwecke und bieten Datenisolierung.

DSGVO, revDSG und der rechtliche Rahmen

Die EU-Datenschutzgrundverordnung (DSGVO) und das Schweizer revDSG schreiben Transparenz, Datensparsamkeit und Zweckbindung vor. Unternehmen müssen nachweisen können, dass sie personenbezogene Daten rechtmässig verarbeiten.

Das bedeutet: Wer KI-Tools im beruflichen Umfeld nutzt, braucht einen Vertrag zur Auftragsdatenverarbeitung (AVV). Nur so kann der Anbieter rechtlich verpflichtet werden, die Datenschutzstandards einzuhalten.

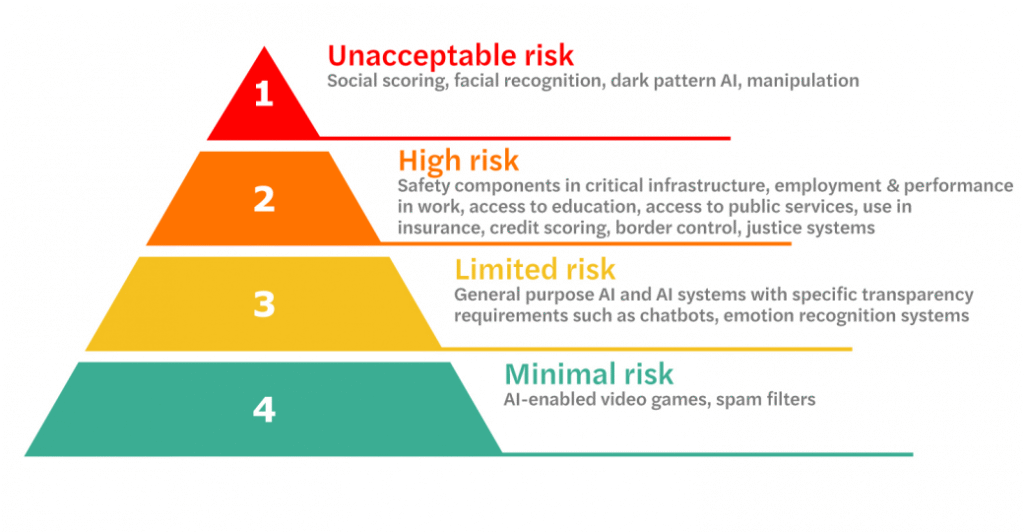

Die Europäische Datenschutzbehörde (EDPB) hat mehrfach betont, dass KI-Systeme künftig stärker reguliert werden müssen. Der EU AI Act soll 2026 in Kraft treten und Hochrisiko-Anwendungen besonders streng überwachen.

Ethik und Verantwortung

Datenschutz ist kein bürokratisches Hindernis, sondern ein ethischer Rahmen.

Wer KI nutzt, trägt Verantwortung – für die eigenen Daten und für das Vertrauen anderer.

Heise Online bringt es auf den Punkt: Datenschutz und Künstliche Intelligenz gehören untrennbar zusammen. Wer Systeme ohne Datenschutz einsetzt, zerstört das Vertrauen, das Innovation braucht.

Das Konzept Privacy by Design – also Datenschutz von Anfang an – wird zur Grundbedingung moderner Technologie. Denn je mehr Daten wir bereitwillig teilen, desto grösser die Macht weniger Plattformen.

Ausblick

Forschung und Industrie arbeiten längst an Lösungen, die KI-Leistung und Datenschutz vereinen.

Ansätze wie Federated Learning, Differential Privacy oder Zero-Knowledge-Proofs zeigen Wege, wie Modelle trainieren können, ohne persönliche Daten offenzulegen.

OpenAI, Microsoft und europäische Firmen wie Aleph Alpha oder Mistral investieren gezielt in diese Technologien.

Langfristig wird sich jene KI durchsetzen, die nicht nur intelligent, sondern auch vertrauenswürdig ist.

Fazit

Künstliche Intelligenz verändert, wie wir arbeiten, lernen und denken.

Aber sie darf das nicht auf Kosten unserer Privatsphäre tun.

Der Umgang mit KI ist kein technisches, sondern ein kulturelles Thema.

Wer versteht, was mit den eigenen Daten passiert, nutzt KI selbstbewusster – und schützt zugleich die Grundlage digitaler Freiheit.